Hello World

Welcome to Hexo! This is your very first post. Check documentation for more info. If you get any problems when using Hexo, you can find the answer in troubleshooting or you can ask me on GitHub.

Quick StartCreate a new post1$ hexo new "My New Post"

More info: Writing

Run server1$ hexo server

More info: Server

Generate static files1$ hexo generate

More info: Generating

Deploy to remote sites1$ hexo deploy

More info: Deployment

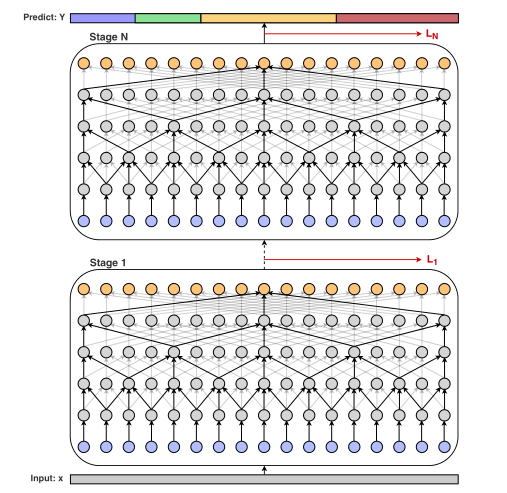

MS-TCN:Multi-Stage Temporal Convolutional Network for Action Segmentation

MS-TCN:用于动作分割的多阶段时间卷积网络摘要传统方法:首先生成逐帧概率,然后再将其送到高级时间模型

最近方法:采用时间卷积直接对视频的每一帧进行分类

本文:提出了一种用于时间动作分割任务的多阶段架构,每个阶段都具有一组扩张时间卷积,用来生成由下一个阶段细化的初始预测。损失函数包含分类损失和平滑损失,平滑损失能够对过度分割的情况进行惩罚。

实验数据集包括:50Salads、Georgia Tech Egocentric Activities (GTEA)、the Breakfast dataset

简介早期动作分割方法包括滑动窗口方法和马尔可夫模型,但是它们的检测速度非常慢。

随着语音模型的发展,依靠时间卷积来捕获视频帧之间的远程依赖关系的方法受到关注,但是这些方法依旧存在检测速度慢、一秒只有几帧的缺陷。

该文章提出了一种多阶段时间卷积网络,通过对视频的全时间分辨率进行操作从而获得更好的检测结果。

该模型每一个阶段的输出都是下一个阶段的输入。在每一个阶段中都使用一系列的一维空洞卷积,使得模型能引入更少的参数而获得更大的时间感受野。同时,采用平滑损失来惩罚过度分割的错误。

本文贡献: ...

深度学习计算

F.Relu和nn.Relu的区别:F.relu是作为一个函数去计算relu,使用方法为:F.relu(X)

nn.Relu是作为一个层结构,必须添加到nn.Module容器内才能使用。

从嵌套块中收集参数:

1234567891011121314def block1(): return nn.Sequential(nn.Linear(4, 8), nn.ReLU(), nn.Linear(8, 4), nn.ReLU())def block2(): net = nn.Sequential() for i in range(4): # 在这里嵌套 net.add_module(f'block {i}', block1()) return netrgnet = nn.Sequential(block2(), nn.Linear(4, 1))rgnet(X)print(rgnet)

李沐都d2l库代码纠错

torch.py中的train_epoch_ch3函数:将273行和第275行的l后面加上mean()

torch.py中的class Animator(动态绘图部分):在其add函数的倒数第二行加入:plt.draw();plt.pause(0.001)

多层感知机

torch.nn.Parameter:是继承自torch.Tensor的子类,其主要作用是作为nn.Module中的可训练参数使用。它与torch.Tensor的区别就是nn.Parameter会自动被认为是module的可训练参数,即加入到parameter()这个迭代器中去;而module中非nn.Parameter()的普通tensor是不在parameter中的。注意到,nn.Parameter的对象的requires_grad属性的默认值是True,即是可被训练的,这与torth.Tensor对象的默认值相反。在nn.Module类中,pytorch也是使用nn.Parameter来对每一个module的参数进行初始化的。

对模型预加载参数:12345def init_weights(m): if type(m) == nn.Linear: nn.init.normal_(m.weight, std=0.01)net.apply(init_weights)

线性回归

nn库的神经网络构建函数:优化器函数:1trainer = torch.optim.SGD(net.parameters(), lr=0.03)

SGD为一个优化器函数,做的是均值损失,数学公式如下:

(\mathbf{w},b) \leftarrow (\mathbf{w},b) - \frac{\eta}{|\mathcal{B}|} \sum_{i \in \mathcal{B}} \partial_{(\mathbf{w},b)} l^{(i)}(\mathbf{w},b).

\begin{aligned} \mathbf{w} &\leftarrow \mathbf{w} - \frac{\eta}{|\mathcal{B}|} \sum_{i \in \mathcal{B}} \partial_{\mathbf{w}} l^{(i)}(\mathbf{w}, b) = \mathbf{w} - \frac{\eta}{|\mathcal{B}|} \sum_{i \in \mathcal{B}} \mathbf{x}^{(i)} \left(\mathbf{w}^\t ...

6_2图像卷积疑问及解答

问题1:卷积是什么?解答1:小明吃饭举例说明,有个小明一天到晚在吃东西,时间和他吃下去的东西的函数图像如下图所示:

他消化的速率如下图所示:

卷积的公式为:

\int_{+\infty}^{-\infty}{f(Z)g(X-Z)dZ}用f函数表示进食,g函数表示消化,带入到卷积公式之中.注意,g函数表示的是消化后剩余食物所占的比例.

这里要表现的东西其实用一根线将f函数和g函数联系了起来.

一个系统输入不稳定(对应f函数),但是输出稳定(对应g函数),可以用卷积来求系统存量.

讲其对应到可视化图像上,其实就是讲g函数翻转了一下和f函数对应相乘,因为翻转了,所以对应叫做卷积.

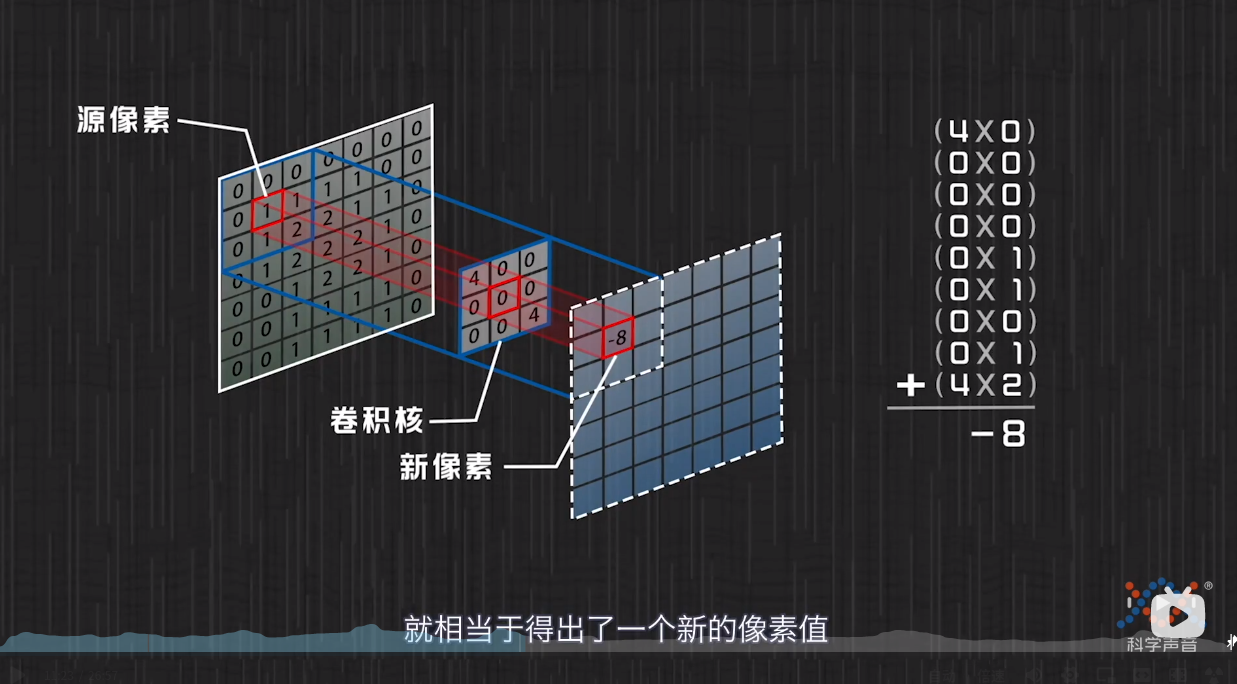

问题2:如何将卷积公式与计算机图像处理对应起来解答2:

上图为计算机对图片进行卷积处理的解释,和前面的卷积公式有一对应结构:先相乘再相加,然后得到一个新的像素值.

但是这么做会导致图像少一圈像素,那么就在原图像的外围加一圈0的像素点,如下图所示:这样就能得到同样大小的图片

图像对应卷积公式中的f函数,卷积核对应g函数,这里与吃东西不同之处在于这里是一个二维的问题.

问题3:如何理解卷积本质?解答3:在一个 ...

解决hexo3.0以上版本无法直接显示插入的图片的问题

问题描述hexo选择3.0以上版本,通过常规md文件的编写方式无法在网页中显示图片。

解决方法:在博客根目录下用命令行:hexo3.0及以上版本一定要用该指令进行安装!!!

1npm install https://github.com/7ym0n/hexo-asset-image --save

该指令是指安装修改后的hexo-asset-image,可适用于hexo3.0及以上版本。

网上的教程多数是使用如下命令进行安装,在hexo3.0版本下是错误的!!!

1npm install https://github.com/hexo-asset-image --save # hexo3.0以上版本不要用这条语句

然后在博客根目录下的_config.yml文件中将“post_asset_folder:”设置为”true“,这样在通过指令hexo new “文章标题”时,不仅会创建一个md文件,还会创建一个和md文件同名的文件夹。将md文件中将要用到的图片存储在这个文件夹下,在需要使用的时候在md文件中通过:

1{% asset_img sky2.jpg This is an ...